Pour ne pas rater un projet d’innovation : pensez à la métaphore du train.

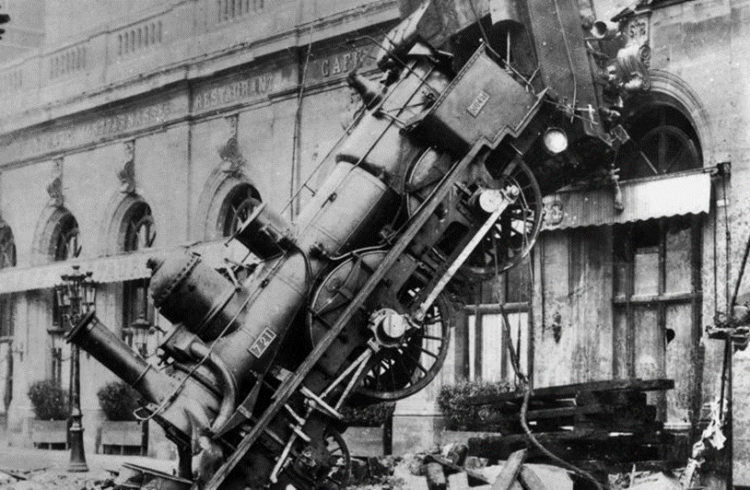

Accident ferroviaire à la gare Montparnasse. Source : Wikipedia.

Cela fait un paquet d’années que j’observe, et parfois participe, à des projets d’innovation alliant une composante produit/marketing et une composante technique. Cette association me fait penser à celle de deux rails sur lesquels on doit faire rouler une locomotive pour arriver à destination.

Filons la métaphore et distribuons les rôles :

- Le rail de gauche est le marketing.

- Le rail de droite est la R&D.

- La locomotive est le projet.

- Le terminus est la réussite du projet !

Et pour que la métaphore soit efficace, précisons que les rails ne sont pas tous posés au moment où la locomotive démarre. Ca c’est l’agilité dont la nécessité est maintenant reconnue par chacun : on sait en effet rarement, au début d’un projet d’innovation, comment tout va se dérouler et une partie du chemin va être définie pendant que le train roule.

En voiture !

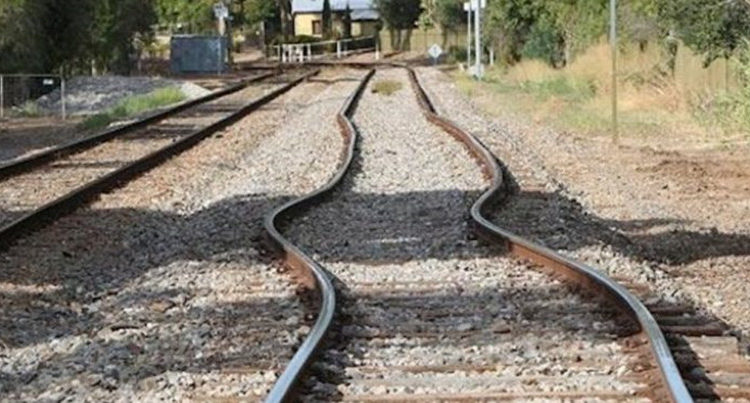

On comprend vite qu‘il est absolument nécessaire que les deux rails restent toujours parallèles pour que la locomotive ne déraille pas, et ce sur toute la longueur du trajet.

Pour qu’il en soit ainsi, il va donc être nécessaire que chacun des rails ne s’occupe pas que de sa propre trajectoire mais se mette au service de la locomotive et de la destination en prenant constamment en considération les tendances de l’autre rail. C’est aussi une condition nécessaire à l’utilisation de méthodes agiles afin de toujours choisir le meilleur chemin au bénéfice du projet.

Si un des rails décide de virer sans que l’autre ne s’adapte, c’est la catastrophe.

Et dans une entreprise il existe plusieurs raisons pour qu’un rail refuse de s’adapter au mouvement d’un autre :

- L’objectif commun (= la destination) est mal connu. Ce cas est, bizarrement, très fréquent. Il se rencontre lorsque la raison d’être du projet n’est pas bien définie, ou mal comprise, ou non partagée.

- Les convictions ne sont pas partagées. Chacun pense que sa direction est la bonne, sans considérer qu’une direction ne peut être bonne que si elle est partagée.

- Les intérêts de l’un ne sont pas alignés avec ceux de l’autre. C’est aussi une situation courante, en particulier lorsqu’existe une forte composante politique dans l’entreprise. Chacun pense alors à son propre bénéfice, aux dépens du bénéfice global. J’ai souvent rencontré ce cas quand une équipe technique profite du fait que les personnes « produit » ne maîtrisent pas bien les composantes technologiques pour imposer des choix qui correspondent à leurs compétences acquises, à leurs convictions ou tout simplement à leur envie du moment… …quitte à totalement transformer le produit dont le développement avait pourtant été jugé souhaitable pour l’entreprise.

Ensuite, pour que la locomotive avance quand même, un des rails risque de suivre aveuglement l’autre sans comprendre ni requestionner les choix. Le risque est alors grand pour que la locomotive roule bien, longtemps, et n’arrive pas à sa destination mais dans un mur.

Prenons le cas concret qui a fait naître ce billet : dans cette entreprise, l’équipe technique (rail de droite) composée de forts caractères a imposé ses choix techniques, éloignés des besoins clients énoncés par l’équipe projet (rail de gauche) qui n’avait pas les compétences nécessaires pour les contester. « Ha ça ce n’est pas possible », « ha là ça c’est beaucoup trop compliqué », « mais il faut absolument ajouter ces fonctions… »…

Quand le rail de droite a dévié. Le gauche n’a pu que le suivre pour rester parallèle. La locomotive a donc pu avancer sans bien entendu arriver là où elle aurait dû, d’où l’échec commercial.

Un projet compliqué ? Pas grave si les parties prenantes travaillent ensemble à son succès. Source : lerail.com

En synthèse, tout cela tourne autour d’une valeur principale : le « projet commun ».

Il est important, dans un tel projet, que chacun apporte sa valeur propre liée à sa compétence, mais garde aussi toujours du recul afin de comprendre en quoi chaque action bénéficie au projet global.

Vous travaillez à un projet d’innovation ? Posez-vous donc les questions suivantes :

En début de projet :

- Quelle est la destination ?

- Est-elle comprise et partagée par tous ?

- Quels sont les rails ?

- Qui en dirige la pose ?

- Quels sont les intérêts personnels de chacun et en quoi l’arrivée du train à destination y contribue ?

Et à tout moment du projet :

- Cette orientation me semble-t-elle me rapprocher de la destination ?

- Cette route est-elle dans l’intérêt des poseurs de l’autre rail ?

- Les rails que je pose sont-ils en accord avec ceux d’à côté ?

Se poser ces questions et y répondre honnêtement aurait certainement pu éviter le déraillement de nombreux trains.